近日,芝加哥大学研究人员开发了一种新工具:它可以通过给图像数据“下毒”来防止艺术作品被喂给AI模型用于训练。

这个名为Nightshade的工具可以微调数字图像数据——人眼不可见,但会导致生成式训练模型(如 DALL-E、Midjourney 和 Stable Diffusion)出现各种故障。

这种技术被其称为“数据毒化”,声称可以在训练时向AI引入“意外行为”。芝加哥大学团队表示,根据他们的研究论文,这种毒化攻击可以“出奇制胜”。目前对该技术的具体工作方式并未彻底公开,但大概是以人眼不可见的方式改变图像像素,同时导致机器学习模型导出错误内容。据称,毒化数据十分顽固,必须手动识别并把毒化图像从模型中一个个地删除。

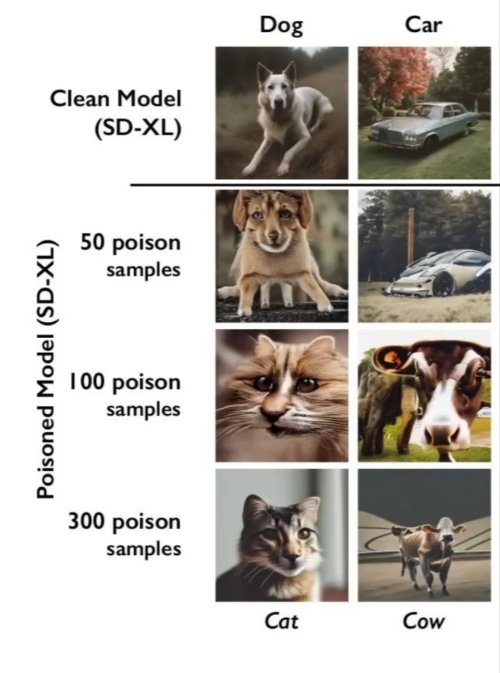

研究人员使用Stable Diffusion作为测试对象,发现只需要300个毒化样本就可以使模型出错——认为一只狗是一只猫,或者认为一顶帽子是一个蛋糕。他们还表示,毒化图像的影响可能会扩展到相关概念(狗下面的哈士奇、比熊犬;帽子下面的牛仔帽、棒球帽)。

本文由游民星空制作发布,未经允许禁止转载。